Binnenin een AI-computer: waarom moderne AI-systemen zo veel geheugen verbruiken

Hoe een AI-server er echt uitziet wanneer je de behuizing opent

Er is momenteel veel rumoer over AI die “te veel geheugen” gebruikt. De prijzen stijgen. De beschikbaarheid is beperkt. Iedereen zegt dat de vraag explodeert. Dat heb je waarschijnlijk al gelezen.

Maar het meeste wat hierover wordt geschreven, slaat het belangrijkste deel over: hoe een AI-computer er fysiek uitziet en waarom hij überhaupt zo veel geheugen nodig heeft. Niet in abstracte grafieken of marktvoorspellingen, maar in termen die je je kunt voorstellen. Zodra je begrijpt wat één enkel AI-systeem daadwerkelijk verbruikt, klinkt de rest van het verhaal niet meer dramatisch, maar onvermijdelijk.

Onlangs legde ik dit uit op een plek die niets met datacenters te maken heeft. Ik was op de school van mijn kind tijdens een “ouderdag”, stond in een klaslokaal, en een paar leerlingen begonnen vragen te stellen over AI. Geen chatbotvragen. Echte vragen. Hoe ziet de computer eruit? Waar gaan de gegevens naartoe? Waarom heeft iedereen het steeds over “geheugen”, alsof dat het hele verhaal is?

Dus begon ik bij het begin. Ik vroeg hen zich een gewone computer voor te stellen. Een die je thuis zou gebruiken. Die heeft een processor die rekent, geheugen dat vasthoudt waar hij op dat moment mee bezig is, en opslag die dingen bewaart voor later. Huiswerk. Foto’s. Spellen. Alles heeft zijn plek.

Daarna legde ik uit dat AI nog steeds een computer is, maar geen computer die één kleine taak tegelijk uitvoert. Hij verwerkt enorme hoeveelheden berekeningen over enorme hoeveelheden data, keer op keer, vergelijkt patronen, past gewichten aan, slaat checkpoints op en doet dat allemaal zo snel dat wachten op opslag de grootste vijand wordt.

Daarom wordt geheugen de hoofdrolspeler. Niet omdat het hip is. Maar omdat de GPU’s zonder voldoende geheugen en snelle opslag simpelweg staan te wachten — en dat is alsof je een raceauto koopt en hem laat staan omdat de weg te smal is.

Een AI-server is geen enkele desktopkast. Hij lijkt meer op een extreem dicht opeengepakte workstation op steroïden. Een gangbare trainingsserver heeft tegenwoordig acht GPU’s, en elke GPU heeft zijn eigen ultrasnelle geheugen om het rekenwerk bij te houden. Daarnaast beschikt de server over een grote hoeveelheid systeemgeheugen om de GPU’s zonder knelpunten te voeden, en vervolgens over een reeks NVMe-SSD’s in de behuizing om datasets klaar te zetten en tussentijdse resultaten weg te schrijven.

Wanneer je een echte stuklijst van zo’n machine ziet, is dat niet subtiel. Je kijkt naar honderden gigabytes GPU-geheugen, vaak een halve terabyte tot meerdere terabytes systeem-RAM, en tientallen terabytes aan NVMe-SSD-opslag binnen één enkele server. Niet over het netwerk. Niet in een gedeelde SAN. In één kast.

Dat is meestal het moment waarop het stil wordt in de ruimte, omdat de schaal ineens echt voelbaar wordt. Eén server kan meer flashopslag bevatten dan de meeste huishoudens ooit zullen bezitten. En AI schaalt niet door één server toe te voegen en het daarbij te laten. Het schaalt door er tientallen of honderden tegelijk toe te voegen, omdat het trainen van grote modellen een teamsport is. Eén machine draagt de last niet alleen.

Dus als één AI-server ongemerkt twintig of dertig terabyte aan flash verbruikt, wat gebeurt er dan wanneer je er honderd inzet? Dan heb je het ineens over petabytes aan NAND-flash die in één enkele uitrol worden verbruikt — en dat nog voordat je gedeelde opslagsystemen, replicatie, back-ups, logging en de “we hebben het sneller nodig dan vorig kwartaal”-upgrades meerekent die beginnen zodra het cluster in productie gaat.

Dit is het punt waarop verhalen over geheugentekorten ophouden hype te lijken en beginnen te klinken als eenvoudige rekenkunde. Geheugenfabrieken verschijnen niet van de ene op de andere dag. Flash en DRAM hebben jaren nodig voor planning, bouw, kwalificatie en opschaling. Zelfs wanneer koppen over schommelende geheugenprijzen verschijnen, verdwijnen de onderliggende aanbodbeperkingen niet wanneer de vraag in datacenter-grote blokken arriveert.

Daarna komt de tweede golf: systemen op rackschaal. In plaats van elke server als een afzonderlijke machine te behandelen, bouwen leveranciers nu complete racks die zich gedragen als één computer. Tientallen GPU’s in één rack, enorme geheugenpools, rijen SSD’s strak naast elkaar. Afstanden worden gemeten in centimeters, niet in meters, omdat snelheid zo belangrijk is.

Op dat punt stel je niet langer de vraag: “Hoeveel geheugen heeft één computer nodig?” Je vraagt: “Hoeveel geheugen heeft één rack nodig?” En dat is precies waarom consumentenelektronica de druk voelt. Niet omdat consumenten ineens twee keer zoveel telefoons kopen, maar omdat er een andere koper is verschenen met een totaal andere schaal van vraag, die in blokken koopt die lijken op complete datacenters.

Op opslagniveau verklaart dit ook waarom lang bestaande aannames over het gedrag van flashgeheugen beginnen te wankelen. Wanneer AI-workloads de vraag domineren, worden onderscheidingen zoals MLC versus TLC NAND niet langer academisch en beginnen ze heel concreet invloed te hebben op beschikbaarheid, levensduur en toewijzingsbeslissingen.

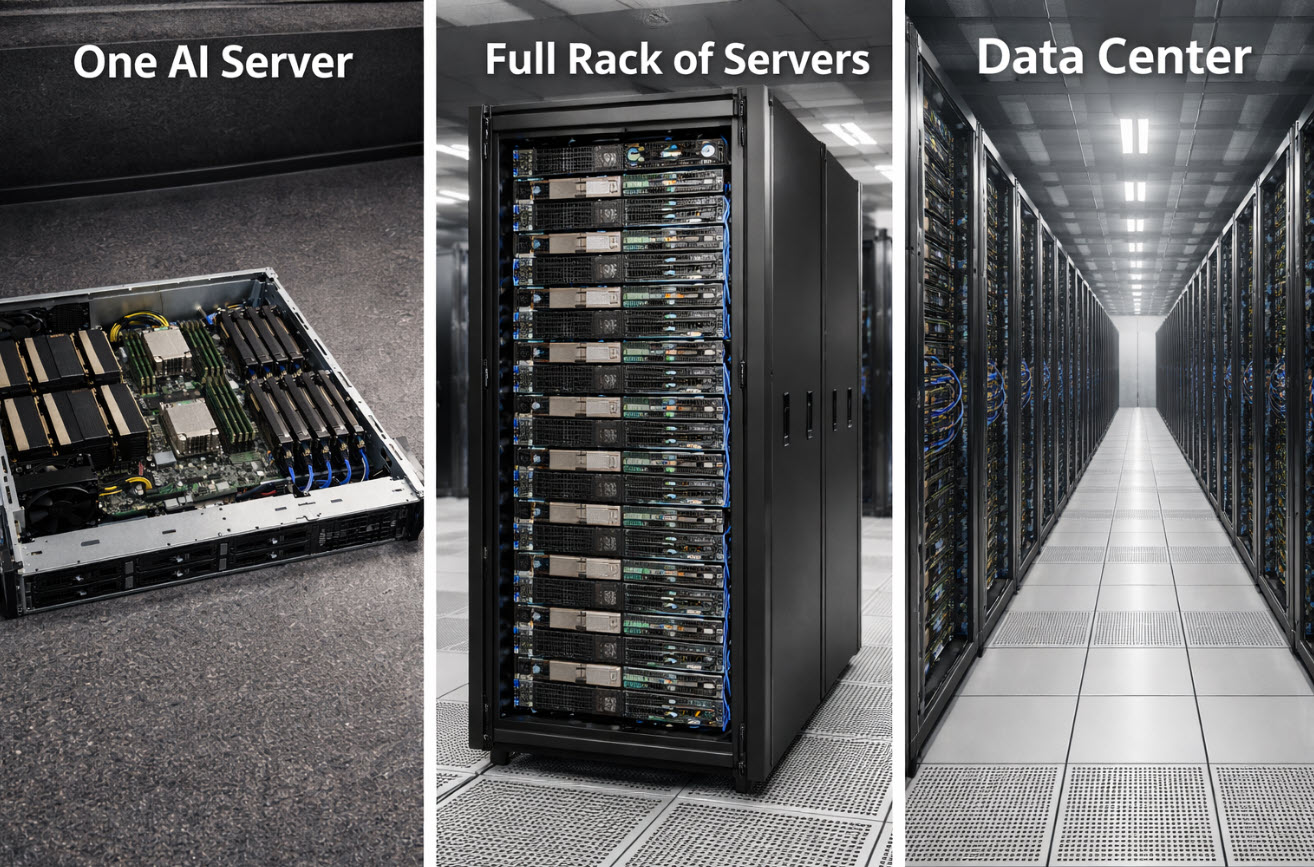

De kinderen hadden geen college over de toeleveringsketen nodig om dit te begrijpen. Ze hadden alleen het beeld nodig. Eén kast wordt een rij. Een rij wordt een rack. Een rack wordt een ruimte. Een ruimte wordt een gebouw. Zodra je AI ziet als infrastructuur en niet als magie, wordt het geheugenverhaal fysiek, mechanisch en voorspelbaar.

En dat is precies het punt. Dit is geen mysterieus tekort. Het is een voorspelbare botsing tussen capaciteit die jaren kost om te bouwen en vraag die van de ene op de andere dag kan verschijnen in de vorm van een paar vrachtwagens vol servers op weg naar een gebouw ter grootte van een magazijn.

Kort gezegd: AI gebruikt niet alleen meer geheugen dan voorheen. Het herdefinieert wat überhaupt een “normale” hoeveelheid geheugen is.

Hoe dit artikel tot stand is gekomen

Auteursbio hieronder — Specialist in USB-opslagsystemen en duplicatie

Dit artikel is opgesteld met AI-ondersteuning voor structuur en formuleringen, en vervolgens door een menselijke auteur beoordeeld, bewerkt en afgerond om de duidelijkheid, nauwkeurigheid en praktische relevantie te verbeteren.

Beeldvermelding

De afbeelding bovenaan dit artikel is met behulp van kunstmatige intelligentie gegenereerd voor illustratieve doeleinden. Het is geen foto van echte omgevingen.

Labels:AI-infrastructuur, datacenters, geheugentekort, NAND-flash, SSD-vraag